用户中心

,几乎是所有互联网公司,必备的子系统。随着数据量不断增加,吞吐量不断增大,用户中心的架构,该如何演进呢。

用户中心是一个通用业务,主要

提供用户注册、登录、信息查询与修改的服务

。

User(uid, login_name, passwd, sex, age, nickname, …)

(2)

login_name, passwd, sex

等是用户属性;

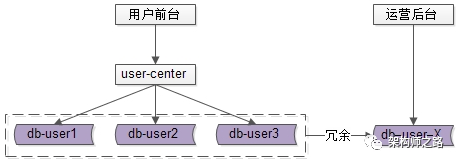

在业务初期,

单库单表

,配合

用户中心微服务

,就能满足绝大部分业务需求,其典型的架构为:

(1)

user-center

:用户中心服务,对调用者提供友好的RPC接口;

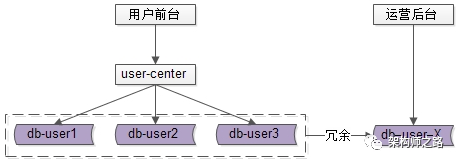

当数据量越来越大,例如达到1亿注册量时,会出现什么问题呢?

随着数据量越来越大,单库无法承载所有的数据,

此时需要对数据库进行水平切分。

常见的水平切分算法有“

范围法

”和“

哈希法

”。

范围法,以用户中心的业务主键

uid

为划分依据,

采用区间的方式

,将数据水平切分到两个数据库实例上去:

(1)

user-db1

:存储0到1千万的

uid

数据;

(2)

user-db2

:存储1千万到2千万的

uid

数据;

(1)

切分策略简单

,根据

uid

,按照范围,

user-center

很快能够定位到数据在哪个库上;

(2)

扩容简单

,如果容量不够,只要增加

user-db3

,拓展2千万到3千万的

uid

即可;

(2)

数据量不均

,新增的

user-db3

,在初期的数据会比较少;

(3)

请求量不均

,一般来说,新注册的用户活跃度会比较高,故

user-db2

往往会比

user-db1

负载要高,导致服务器利用率不平衡;

画外音:数据库层面的负载均衡,既要考虑数据量的均衡,又要考虑负载的均衡。

哈希法,也是以用户中心的业务主键

uid

为划分依据,

采用哈希的方式

,将数据水平切分到两个数据库实例上去:

(1)

user-db1

:存储奇数的

uid

数据;

(2)

user-db2

:存储偶数的

uid

数据;

(1)

切分策略简单

,根据

uid

,按照hash,

user-center

很快能够定位到数据在哪个库上;

(2)

数据量均衡

,只要

uid

是随机的,数据在各个库上的分布一定是均衡的;

(3)

请求量均衡

,只要

uid

是随机的,负载在各个库上的分布一定是均衡的;

画外音:如果采用分布式id生成器,id的生成,一般都是随机的。

(1)

扩容麻烦

,如果容量不够,要增加一个库,重新hash可能会导致数据迁移;

用户中心架构,实施了水平切分之后,会带来什么新的问题呢?

使用

uid

来进行水平切分之后,

对于

uid

属性上的查询,可以直接路由到库

,假设访问

uid=124

的数据,取模后能够直接定位

db-user1

:

但

对于非

uid

属性上的查询,就悲剧了

,例如

login_name

属性上的查询:

假设访问

login_name=shenjian

的数据,由于不知道数据落在哪个库上,

往往需要遍历所有库

,当分库数量多起来,性能会显著降低。

在进行架构讨论之前,先来对业务进行简要分析,用户中心非

uid

属性上,有两类典型的业务需求。

第一大类,用户侧,前台访问

,最典型的有两类需求:

(1)用户登录:通过登录名

login_name

查询用户的实体,1%请求属于这种类型;

(2)用户信息查询:登录之后,通过

uid

来查询用户的实例,99%请求属这种类型;

用户侧的查询,基本上是

单条记录的查询,访问量较大,服务需要高可用,并且对一致性的要求较高

。

第二大类,运营侧,后台访问

,根据产品、运营需求,访问模式各异,按照年龄、性别、头像、登陆时间、注册时间来进行查询。

运营侧的查询,基本上是

批量分页

的查询,由于是内部系统,

访问量很低,对可用性的要求不高,对一致性的要求也没这么严格

。

对于这两类不同的业务需求,应该使用什么样的架构方案来解决呢?

总的来说,针对这两类业务需求,架构设计的核心思路为:

(1)用户侧,采用“

建立非

uid

属性到

uid

的映射关系

”的架构方案;

(2)运营侧,采用“

前台与后台分离

”的架构方案;

用户侧,如何实施“建立非

uid

属性到

uid

的映射关系”呢?

索引表法的思路是:

uid

能直接定位到库,

login_name

不能直接定位到库,如果

通过

login_name

能查询到

uid

,问题便能得到解决。

(1)建立一个索引表记录

login_name

与

uid

的映射关系;

(2)用

login_name

来访问时,

先通过索引表查询到

uid

,再通过

uid

定位相应的库

;

(3)索引表属性较少,可以容纳非常多数据,一般不需要分库;

(4)如果数据量过大,可以通过

login_name

来分库;

数据访问,

会增加一次数据库查询

,性能会有所下降。

缓存映射法的思路是:访问索引表性能较低,

把映射关系放在缓存里

,能够提升性能。

(1)

login_name

查询先到

cache

中查询

uid

,再根据

uid

定位数据库;

(2)假设

cache miss

,扫描所有分库,获取

login_name

对应的

uid

,放入

cache

;

(3)

login_name到uid的映射关系不会变化,映射关系一旦放入缓存,不会更改,无需淘汰,缓存命中率超高

;

(4)如果数据量过大,可以通过

login_name

进行

cache

水平切分;

仍然多了一次网络交互

,即一次

cache

查询。

生成

uid

法的思路是:

不进行远程查询,由

login_name

直接得到

uid

。

(1)在用户注册时,

设计函数

login_name

生成uid

,

uid=f(login_name)

,按uid分库插入数据;

(2)用

login_name

来访问时,先通过函数计算出uid,即

uid=f(login_name)

再来一遍,由uid路由到对应库;

该函数设计需要非常讲究技巧,且

有uid生成冲突风险

。

画外音:uid冲突,是业务无法接受的,故生产环境中,一般不使用这个方法。

基因法的思路是:不能用

login_name

生成uid,但可以

从

login_name

抽取“基因”,融入uid中

。

假设分8库,采用uid%8路由,潜台词是,uid的最后3个bit决定这条数据落在哪个库上,这3个bit就是所谓的“基因”。

(1)在用户注册时,

设计函数

login_name

生成3bit基因,

login_name_gene = f(login_name)

,如上图粉色部分;

(2)同时,生成61bit的全局唯一id,作为用户的标识,如上图绿色部分;

(3)接着

把3bit的

login_name_gene

也作为uid的一部分

,如上图屎黄色部分;

(4)生成64bit的uid,由id和

login_name_gene

拼装而成,并按照uid分库插入数据;

(5)用

login_name

来访问时,先通过函数由

login_name

再次复原3bit基因,

login_name_gene = f(login_name)

,通过

login_name_gene

%8直接定位到库;

前台用户侧,业务需求基本都是

单行记录的访问

,只要建立非uid属性

login_name

到uid的映射关系,就能解决问题。

后台运营侧,业务需求各异,基本是

批量分页的访问

,这类访问计算量较大,返回数据量较大,比较消耗数据库性能。

此时,前台业务和后台业务共用一批服务和一个数据库,有可能导致,由于后台的“少数几个请求”的“批量查询”的“低效”访问,导致数据库的cpu偶尔瞬时100%,影响前台正常用户的访问(例如,登录超时)。

而且,为了满足后台业务各类“奇形怪状”的需求,往往会在数据库上建立各种索引,这些索引占用大量内存,会使得用户侧前台业务uid/

login_name

上的查询性能与写入性能大幅度降低,处理时间增长。

对于这一类业务,应该采用“前台与后台分离”的架构方案。

用户侧前台业务需求架构依然不变,产品运营侧后台业务需求则抽取

独立的

web / service / db

来支持

,解除系统之间的耦合,对于“业务复杂”“并发量低”“无需高可用”“能接受一定延时”的后台业务:

(1)可以去掉

service

层,在运营后台

web

层通过

dao

直接访问

db

;

(3)不需要访问实时库,可以通过

MQ

或者线下异步同步数据;

(4)在数据库非常大的情况下,可以使用更契合大量数据允许接受更高延时的“索引外置”或者“

HIVE

”的设计方案;

用户中心,是典型的“单KEY”类业务,这一类业务,

都可以使用上述架构方案

。

(1)通过uid属性查询能直接定位到库,

通过非uid属性查询不能定位到库

;

(1)用户侧,前台访问,单条记录的查询,访问量较大,服务需要高可用,并且对一致性的要求较高;

(2)运营侧,后台访问,根据产品、运营需求,访问模式各异,基本上是批量分页的查询,由于是内部系统,访问量很低,对可用性的要求不高,对一致性的要求也没这么严格;

(1)用户侧,采用“

建立非uid属性到uid的映射关系

”的架构方案;

(2)运营侧,采用“

前台与后台分离

”的架构方案;

前台用户侧,“建立非uid属性到uid的映射关系”,有四种常见的实践:

(1)索引表法:数据库中记录

login_name

与uid的映射关系;

(2)缓存映射法:缓存中记录

login_name

与uid的映射关系;

(3)生成uid法:

login_name

生成uid;

(4)基因法:

login_name

基因融入uid;

(1)前台、后台系统

web/service/db

分离解耦,避免后台低效查询引发前台查询抖动;

(3)可以采用“外置索引”(例如ES搜索系统)或者“大数据处理”(例如

HIVE

)来满足后台变态的查询需求;